Инструменты сайта

Основное

Число обусловленности матрицы

Дается очень интуитивное представление о важной характеристике квадратной матрицы, существенной для решения систем линейных уравнений с этой матрицей.

Пример. Система линейных уравнений $ AX =\mathcal B $ при

$$ A=\left(\begin{array}{rr} -2 & 2 \\ 19 & -18 \end{array} \right), \ B= \left(\begin{array}{c} 1 \\ 2 \end{array} \right),\ X= \left(\begin{array}{c} x_1 \\ x_2 \end{array} \right), $$ имеет решение $ X_0= [11.0, 11.5]^{\top} $. При небольшом возмущении столбца правых частей $ \mathcal B= [1.0,2.1]^{\top} $ решение меняется в пределах того же возмущения: $ X= [11.1, 11.6]^{\top} $. Но вот при $ \mathcal B= [1.1,2.0]^{\top} $ решение изменится более существенно: $ X= [11.9, 12.45]^{\top} $. Обнаруженный эффект принципиально важен для численных методов решения систем линейных уравнений: с какой точностью следует производить вычисления?

Для выяснения причины этого эффекта

будем искать геометрическое место точек плоскости $ \mathbb R^2 $, удовлетворяющих неравенству

$$ (-2 x_1 +2x_2-1)^2+(19x_1 -18 x_2-2)^2 \le \varepsilon^2 \iff $$

$$ \iff (AX-\mathcal B)^{\top}(AX-\mathcal B) \le \varepsilon^2 $$

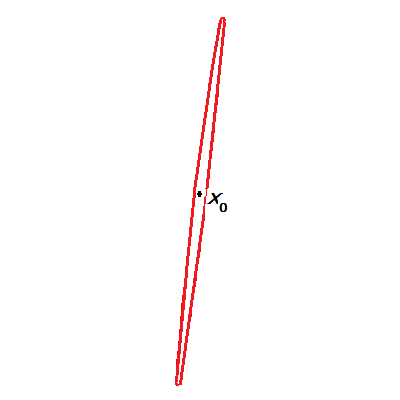

при различных значениях $ \varepsilon $, в частности, при $ \varepsilon = 0.1 $. Очевидным решением является внутренность эллипса с центром в точке $ X_0 $. Этот эллипс оказывается очень «сплюснутым»: так, при $ \varepsilon = 0.1 $, его полуоси равны $ \approx 1.31624 $ и $ \approx 0.00380 $.

При любом выборе $ X $ внутри эллипса погрешность столбца $ \widetilde{\mathcal B}= AX $ относительно столбца $ \mathcal B $ не превосходит $ \varepsilon $. Однако при одной и той же величине погрешности в столбце $ \mathcal B $ соответствующие решения системы могут меняться как очень немного, так и значительным образом.

При любом выборе $ X $ внутри эллипса погрешность столбца $ \widetilde{\mathcal B}= AX $ относительно столбца $ \mathcal B $ не превосходит $ \varepsilon $. Однако при одной и той же величине погрешности в столбце $ \mathcal B $ соответствующие решения системы могут меняться как очень немного, так и значительным образом.

Известно, что форма эллипса, заданного неявным алгебраическим уравнением второго порядка, определяется только мономами второго порядка. В разбираемом примере — элементами матрицы $$ A^{\top} A = \left(\begin{array}{rr} 365 & -346 \\ -346 & 328 \end{array} \right) \, . $$ Полуоси определяются через посредство собственных чисел этой матрицы. Именно, $$ \lambda_1\approx 0.00577, \lambda_2 \approx 692.99422 $$ и длины полуосей равны $ 1/ \sqrt{\lambda_1} $ и $ 1/ \sqrt{\lambda_2} $. В геометрии величина отношения длин малой полуоси к большой называется коэффициентом сжатия эллипса или эллиптичностью. А в алгебре обратная величина, т.е. $$ \sqrt{\lambda_2/\lambda_1} \approx 346.49711 $$ носит другое название. ♦

Для матрицв $ A \in \mathbb R^{n\times n} $ обозначим $ \sigma_{max} $ ее максимальное сингулярное число, а $ \sigma_{min} $ — минимальное. При $ \sigma_{min} \ne 0 $ величина $$ \operatorname{cond} (A)= \sigma_{max}/\sigma_{min} $$ называется числом обусловленности матрицы1)$ A $. Очевидно, $ \operatorname{cond} (A) \ge 1 $. При $ \operatorname{cond} (A) $ близком к $ 1 $ матрица называется хорошо обусловленной, при $ \operatorname{cond} (A) \gg 1 $ матрица $ A $ называется плохо обусловленной2).

Пример. Матрица Вандермонда

$$ V= \left(\begin{array}{ccccc} 1 & 1 & 1 & 1 & 1 \\ 1 & 2 & 2^2 & 2^3 & 2^4 \\ 1 & 3 & 3^2 & 3^3 & 3^4\\ 1 & 4 & 4^2 & 4^3 & 4^4\\ 1 & 5 & 5^2 & 5^3 &5^4 \end{array} \right) $$ может считаться плохо обусловленной: $ \operatorname{cond} (V) \approx 26169 $.

Пример. Матрица Гильберта

$$ \mathfrak H_4= \left[\frac{1}{j+k-1} \right]_{j,k=1}^4 = \left( \begin{array}{cccc} 1 & 1/2 & 1/3 & 1/4 \\ 1/2 & 1/3 & 1/4 & 1/5 \\ 1/3 & 1/4 & 1/5 & 1/6 \\ 1/4 & 1/5 & 1/6 & 1/7 \end{array} \right) $$ плохо обусловлена: $ \operatorname{cond} (\mathfrak H_4) \approx 15513 $.